Uma questão que frequentemente debatemos é se os sistemas de inteligência artificial (IA) são realmente inteligentes e conseguem pensar. Isto é, se suas decisões são pensadas. Neste segundo artigo da série “Desmistificando a IA”, vou debater essa questão.

Turing, um dos pioneiros da computação, em seu paper “Computing Machinery and Inteligence”, de 1950, levantou a questão se era possível as máquinas pensarem. E propôs, no que chamou de o “jogo da imitação”, o que se transformou no Teste de Turing.

Nesse teste, um computador e um humano são questionados, independentemente, por um julgador humano, que tenta determinar qual interlocutor é o humano e qual é a máquina. O julgador está fisicamente separado dos dois e não tem como saber previamente qual é qual.

A proposta de Turing não é dizer se a máquina é inteligente, mas se ela poderá se fazer passar por humano, respondendo de forma que faça com que o julgador considere que esteja conversando com outro humano e não com uma máquina.

O teste deixa passar alguns detalhes. Não está claro que critérios serão usados para o teste ou que tópicos de conversação serão adotados. Ele também não estipula o tempo para o julgador chegar à sua decisão.

Turing chegou a dizer que em 50 anos (em torno do ano 2000), os computadores fariam o “jogo da imitação” tão bem, que um julgador mediano em 70% das vezes dirá que a máquina é humana.

Sua predição foi muito boa! Muitos chatbots, sistemas de IA construídos especificamente para um tipo de conversação, apresentam resultados que enganam muita gente. Mas mesmo sistemas sofisticados como o GPT-3 interpretam e criam textos observando relações estatísticas entre palavras e frases, mas não entendem seu significado.

Isso gera muitas vezes respostas sem sentido, como: “um lápis é mais pesado que uma torradeira”. Por isso, alguns especialistas chamam os modelos de linguagem de “papagaios estocásticos” ou “uma boca sem cérebro” porque eles ecoam o que eles ouvem, remixados ao acaso.

A imensa maioria dos bots que vemos hoje não conseguem manter um diálogo minimante humano e coloquial. Respondem razoavelmente apenas quando a conversa está dentro da caixinha. A questão fundamental é que esses sistemas não compreendem o que estão conversando.

A imensa maioria dos bots que vemos hoje não conseguem manter um diálogo minimante humano e coloquial

O resultado de suas respostas é fruto de fórmulas estatísticas, que apontam que determinado conjunto de palavras terá alta possibilidade de ser a resposta certa naquela determinada situação.

A questão da inteligência é altamente desafiadora, pois existem diversas formas de inteligência. A nossa, dos humanos, é diferente da dos peixes, mas esses animais possuem alguma forma de inteligência.

Um conjunto de algoritmos matemáticos que fazem o que chamamos de sistemas de machine learning (ML) aparentam ter inteligência, mas seus resultados são o produto da interação dos modelos matemáticos com os dados, estes sim fruto da inteligência humana.

Sugiro a leitura de um artigo muito instigante, “Wittgenstein: Intelligence is Never Artificial”, baseado nas ideias do filósofo Ludwig Joseph Johann Wittgenstein, cujas principais contribuições foram feitas nos campos da lógica, filosofia da linguagem, filosofia da matemática e filosofia da mente.

Segundo o filósofo, “compreender uma frase significa compreender uma língua”. Para ele, o problema para a IA é que a linguagem é mais do que uma simples soma de suas partes. O ponto que Wittgenstein faz é que um sistema de IA pode analisar palavras e processá-las como uma sentença, mas não entenderia realmente a sentença como parte da linguagem humana.

Existem outros pontos de vista. A ciência não é determinística e sempre está evoluindo, e, muitas vezes, novos modelos mentais suplantam os modelos então dominantes. De maneira geral, um novo paradigma começa meio desapercebido, aparece inicialmente apenas como um traço nas pesquisas de utilização, quando comparado ao modelo vigente, mas sua curva de adoção aponta rapidamente para cima, até se tornar o modelo mental dominante, substituindo o anterior.

Recomendo a leitura do livro “The Structure of Scientific Revolutions: 50th Anniversary Edition”, de Thomas Kuhn. O livro descreve como surge um novo paradigma e ajuda a entender as reações e desconfianças iniciais que geralmente acompanham as mudanças.

Algumas ideias revolucionárias, como o conceito da singularidade, proposto por Ray Kurzweil, sugere que as máquinas serão inteligentes e que nós nos mesclaremos com elas. Seu livro “The Singularity Is Near: When Humans Transcend Biology” me impactou muito ao lê-lo em torno de 2005.

A sua proposta é que chegaremos a um momento em que o avanço da tecnologia será tão rápido e exponencial, seu impacto tão profundo, que a vida humana será transformada por completo. Nesse ponto, a IA excederá a inteligência humana.

Kurzweil tem um bom histórico de acerto em suas predições, e, claramente, influencia muitas das pesquisas em IA. Ele acredita que seja possível fazer a reengenharia reversa do cérebro humano, possibilitando assim a criação de uma máquina superinteligente.

Kurzweil acredita que seja possível fazer a reengenharia reversa do cérebro humano, possibilitando assim a criação de uma máquina superinteligente

Seu argumento principal é que embora hoje pouco conhecemos do funcionamento do cérebro, o avanço exponencial do conhecimento nos abrirá as portas de seus princípios básicos e aí saberemos como ele funciona.

Mas uma questão que fica é: mesmo que consigamos entender os princípios básicos do funcionamento do cérebro e programá-los em máquinas, como a podemos considerar inteligente?

Uma criança recém-nascida tem cérebro, mas ainda não tem a inteligência que consideramos humana, que só é adquirida com o tempo. Para Kurzweil, a solução também é tecnológica: treinar o sistema com todos os dados possíveis.

Naturalmente, as ideias de Kurzweil tiveram entusiastas e céticos. No início, as achei fantásticas e me alinhei com os entusiastas. Mas, aos poucos comecei a repensar esse entusiasmo. Posteriormente, li um livro fantástico, “What to Think about Machines That Think: Today's Leading Thinkers on the Age of Machine Intelligence”.

O livro é uma fascinante coleção de pontos de vista dos principais acadêmicos e cientistas de todo o mundo em relação às ameaças percebidas do desenvolvimento da IA.

Talvez a visão mais perturbadora de todas seja a de que a maior ameaça que enfrentamos não vem de máquinas cada vez mais “inteligentes”, mas sim da crescente extensão no ritmo em que estamos passando o controle de muitos aspectos de nossas vidas para sistemas computadorizados.

A crise financeira de 2008 foi um dos muitos sintomas dessa abdicação do controle humano. As evidências sugerem que quanto mais delegamos aos sistemas computadorizados que pensem por nós, assumam o controle e façam julgamentos em nosso nome, menos estamos realmente pensando por nós mesmos como seres humanos.

Se for esse o caso, as consequências potenciais são muito mais perturbadoras do que as ameaças potenciais da IA. Como disse um escritor, temos muito mais a temer de humanos que não pensam do que de máquinas inteligentes.

Os pontos de vista dos autores são divergentes, claro, pois é assim que a ciência evolui, mas sua leitura me deu os insights que estão me permitindo criar um novo modelo mental sobre IA.

Hoje, creio que a proposta de Kurzwei seja uma crença em um exacerbado “êxtase tecnológico”, que tem permeado a evolução tecnológica, principalmente da IA, e levado muitos a considerarem a IA como algo além do que ela realmente é.

Por exemplo, a base dos fundamentos da singularidade é a exponencialidade, mas essa não é distribuída de forma similar. A evolução do hardware evolui exponencialmente, mas a tecnologia de software não acompanhou esse ritmo. Não podemos dizer hoje que o software seja milhões de vezes mais sofisticado que o de 50 anos atrás.

“Homo Deus”, de Yuval Noah Harari, provoca um debate interessante sobre o tema e lembra que a diferença fundamental entre seres humanos e máquinas é a diferença entre as relações para conhecimento. Para as máquinas, a fórmula é conhecimento = dados empíricos x matemática.

Se quisermos saber a resposta para uma questão, reunimos dados empíricos e depois usamos ferramentas matemáticas para analisá-los. A fórmula científica do conhecimento leva a descobertas impressionantes na física, medicina e outras áreas.

Mas há um enorme senão: essa fórmula não pode lidar com questões de valor e significado. Aí que entra a fórmula do conhecimento humano, que nos diferencia das máquinas: conhecimento = experiências x sensibilidade.

Experiências são fenômenos subjetivos como sensações (calor, prazer, tensão), emoções (amor, medo, ódio) e pensamentos. A sensibilidade é a atenção às experiências e como elas influenciam a pessoa em suas atitudes e comportamentos.

Entretanto, Harari alerta para o fato que, embora sem dispor de consciência, emoções e sensações, robôs e sistemas de IA estão assumindo o papel que era predominantemente humano em muitas tarefas.

O que Harari propõe é que a inteligência está se desacoplando da consciência. Isso significa que sistemas não conscientes podem ser capazes de realizar algumas tarefas muito melhor que humanos.

À medida que as máquinas eventualmente possam se tornar melhores substitutas de muitas atividades humanas, os trabalhadores perderão poder de barganha econômico e político, e se tornarão cada vez mais dependentes daqueles poucos que controlam a tecnologia.

Em contraste, se a aplicação da IA for focada em aumentar a capacidade dos humanos em vez de imitá-los, para substituí-los, os humanos mantêm parte do valor criado. Além disso, esse aumento de capacidade e produtividade poderá criar novos produtos e serviços, gerando muito mais valor econômico do que aplicações de IA que pretendam substituir a atividade humana.

A IA deve ser usada para aumentar a capacidade humana, não para substituir os humanos. Não pode e nem deve ser uma equação de soma zero, humanos contra máquinas, mas humanos e máquinas.

A IA deve ser usada para aumentar a capacidade humana, não para substituir os humanos. Não pode e nem deve ser uma equação de soma zero

O excelente artigo de Erik Brynjolfsson, diretor do Stanford Digital Economy Lab, “The Turing Trap: The Promise & Peril of Human-Like Artificial Intelligence”, é leitura obrigatória para todos interessados nos impactos da IA na sociedade e economia.

Precisamos ser realistas e buscar a evolução da IA sem modismos ou hype. Enfrentar os desafios da sua evolução (estamos engatinhando), formar talentos de forma adequada e não de forma amadorística, com cursos de “aprenda tudo sobre IA em uma semana”, e principalmente ser coerente nas propostas de projetos em que IA será aplicável.

A IA não é solução para todos nossos problemas. Recomendo o artigo da Scientific American, “AI Isn’t a Solution to All Our Problems”, para uma visão bem equilibrada de onde e como usar IA de forma adequada.

Mantenho a visão que a IA é uma tecnologia transformadora. Em cima dela serão criados novos produtos, serviços e modelos de negócio. E não existe nenhuma inconsistência entre uma visão otimista de longo prazo e as eventuais frustrações que temos no curto prazo. Ambos podem coexistir simultaneamente.

Muitas vezes, criamos falsas expectativas, uma visão simplista que as coisas são muito mais fáceis que na realidade. Na prática, as tecnologias que mudam comportamentos da sociedade demoram muito tempo para se consolidar.

Um exemplo é o comércio eletrônico. No final dos anos 1990, o entusiasmo era imenso, com o surgimento das empresas pontocom. Mas sua adoção significativa pela sociedade levou quase duas décadas para se consolidar. E no meio disso, ainda teve o estouro da bolha das pontocom, quando o mercado identificou que a promessa estava distante.

A IA e seus efeitos em todos os setores da sociedade também deverá seguir trajetória similar. Não veremos, de forma ampla, seus impactos em poucos anos, mas em mais uma ou duas décadas, sentiremos de forma significativa as transformações que ela causará.

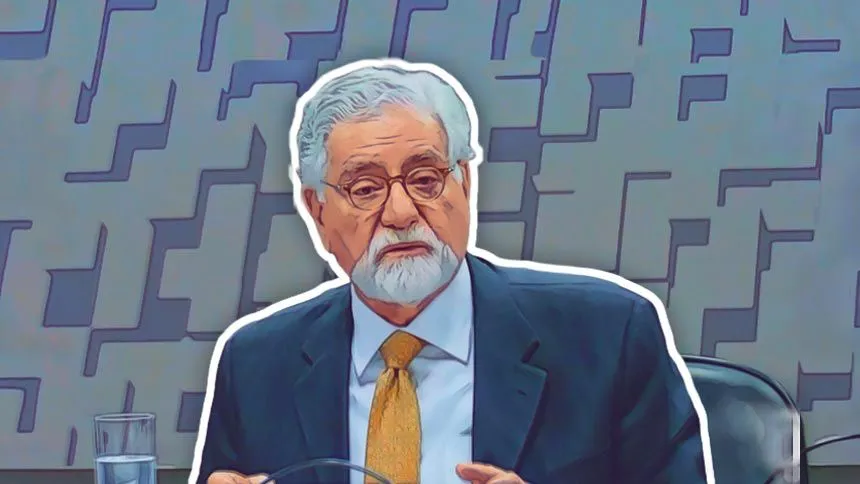

Cezar Taurion é VP de Inovação da CiaTécnica Consulting, e Partner/Head de Digital Transformation da Kick Corporate Ventures. Membro do conselho de inovação de diversas empresas e mentor e investidor em startups de IA. É autor de nove livros que abordam assuntos como Transformação Digital, Inovação, Big Data e Tecnologias Emergentes. Professor convidado da Fundação Dom Cabral, PUC-RJ e PUC-RS.