Recentemente, foi muito comentada a alegação de um engenheiro de machine learning (ML) do Google que disse em entrevistas que o sistema de Deep Learning (DL) LaMDA mostrou sinais de ser senciente e, portanto, parecia demonstrar alguma percepção e compreensão do que estava fazendo. Neste quinto e último artigo série “Desmistificando IA”, vamos analisar esse tema.

Compreensão é a grande barreira do que entendemos pelo termo “Inteligência Artificial”. Os sistemas atuais de IA, como DL, são um complexo conjunto de modelos matemáticos, mas que apenas correlacionam estatisticamente palavras de modo que nos parecem fazer sentido, embora para eles sejam simplesmente resultado das correlações estatísticas.

É verdade que em algumas atividades de reconhecimento de padrões, como análise de imagens, eles conseguem assertividade melhor que nós humanos. Mas essa percepção de inteligência é apenas aparente, pois lhes falta a compreensão do que estão fazendo, o significado das palavras, frases e imagens que estão reconhecendo.

Nós humanos temos o senso comum e mesmo quando bebês, temos uma percepção clara que o mundo é feito de objetos, que as partes de um objeto se movem em conjunto e conseguimos reconhecer objetos parcialmente obstruídos. À medida que crescemos, ampliamos esse senso comum.

Sabemos que um objeto se deslocando para atrás de outro maior, que o oculta temporariamente, continua existindo. Compreendemos as estruturas de causa e efeito. Sabemos que se deixarmos um objeto em cima de uma mesa ele continuará lá, até que alguém o retire.

E tudo isso não aprendemos na escola. Não precisamos de milhares de observações para reconhecer esses contextos. Temos dentro de nós a física intuitiva, a biologia intuitiva (conhecimento de objetos vivos versus inanimados) e psicologia intuitiva (temos percepção dos sentimentos de outras pessoas). Isso nos permite sobreviver como espécie e interagir com o mundo e com outras pessoas e objetos.

As máquinas “aprendem” de outra forma. Elas precisam captar um grande volume de imagens ou textos para que possam identificar padrões reconhecíveis. Podem simular frases e expressões tristes, mas não possuem as emoções que são a raiz dessas expressões.

Por não compreenderem e interagirem com o mundo, não conseguem absorver as diferenças culturais que fazem a sociedade humana. Por isso, o uso de forma simplificada de sistemas de DL, como analisar expressões faciais para reconhecer emoções tendem a falhar. O artigo “Facial Expressions Do Not Reveal Emotions” mostra isso de forma bastante assertiva.

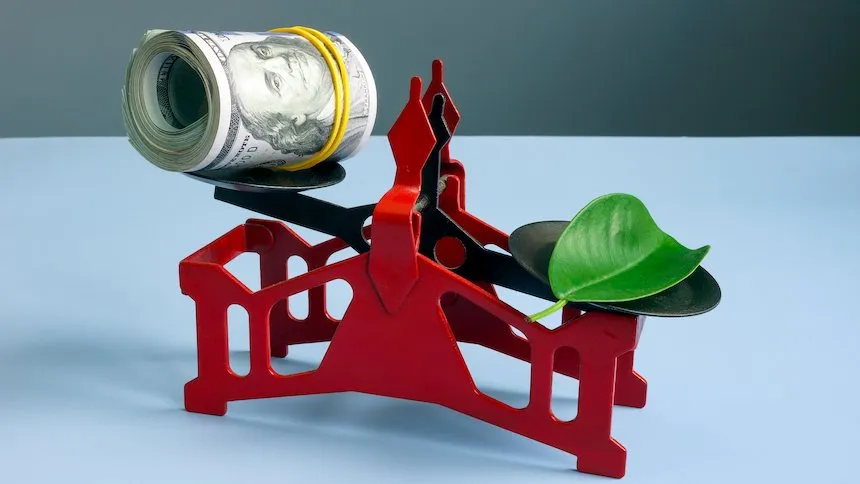

As diferenças entre humanos e máquinas são brutais e o próprio nome IA é incorreto. O artigo “Nonsense on Stilts” joga um pouco de luz nessa questão. Seu autor, Gary Marcus, que publicou o excelente livro “Rebooting AI”, mostra que o LaMDA não é senciente e está muito longe de ser.

As diferenças entre humanos e máquinas são brutais e o próprio nome IA é incorreto

Por exemplo, nós humanos temos o pensamento abstrato. Fazemos analogias e criamos conceitos. Podemos ver uma foto e imaginar toda uma história em torno dela. Podemos ouvir um relato e visualizar as cenas ocorridas, embora não estivéssemos lá.

Os algoritmos de DL são modelos que criam representações matemáticas de pixels. São treinados “vendo” milhares e milhares de imagens de carros que estejam rotulados como “carros”. Quando recebe uma nova foto de carro, ele tenta fazer o casamento matemático com os modelos de pixels que já “aprendeu”. Quando dá match, ele aponta que é um carro. Se não der match, ele aponta para o padrão que mais se aproxima estatisticamente, que pode ser algo como uma tampa de lixeira.

Esse é um aspecto fundamental e que às vezes esquecemos no frenesi do hype: os sistemas de DL não tem bom senso e, portanto, o que causar match, ele indica como resposta, por mais esdrúxulo que seja. Não esqueçam que o algoritmo não tem a mínima ideia do que seja um carro. Ele apenas responde baseado no que foi rotulado. Se, por acaso, todas as imagens de carro fossem rotuladas como gatos, ele apontaria, no caso de match, que as imagens seriam gatos.

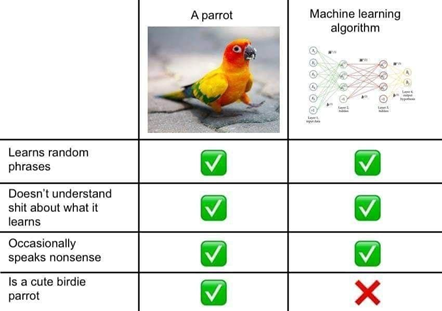

Mesmo sistemas sofisticados como o GPT-3 interpretam e criam textos observando relações estatísticas entre palavras e frases, mas não entende seu significado. Isso gera muitas vezes respostas sem sentido, como "Um lápis é mais pesado que uma torradeira". Por isso, “alguns especialistas chamam os modelos de linguagem de" papagaios estocásticos " ou "uma boca sem cérebro" porque eles ecoam o que eles ouvem, remixados ao acaso.

Apesar dos impressionantes avanços que aparentemente colocam os computadores ao alcance da inteligência humana, suas operações internas desmentem o hype: os computadores não são inteligentes como os humanos. Embora eles possam, por meio da programação e da engenharia inteligente (ambas providas por humanos!), produzir resultados que associamos à inteligência, eles não entendem o que estão fazendo ou vendo.

Eles podem reconhecer uma mancha em uma radiografia e apontar que é um câncer, mas não têm a mínima ideia do que seja um câncer. Muitas vezes nós tratamos nossas criações algorítmicas como se estivessem vivas, proclamando que nosso algoritmo "aprendeu" uma nova tarefa, em vez de meramente induzir um conjunto de padrões estatísticos de um conjunto de dados de treinamento escolhido a dedo, sob a supervisão direta de um humano, que escolheu quais algoritmos, parâmetros e fluxos de trabalho usar para construí-lo.

A tecnologia de IA, (vamos continuar usando o termo, cunhado em 1956, pelo fato de já estar disseminado e pela falta de outro), vai produzir um conjunto extremamente poderoso de ferramentas que nos ajudarão em muitas coisas. Mas são apenas isso, ferramentas. A inteligência artificial é o produto da criatividade e imaginação humana com o uso de rígidos e precisos modelos matemáticos inseridos em computadores.

Cezar Taurion é VP de Inovação da CiaTécnica Consulting, e Partner/Head de Digital Transformation da Kick Corporate Ventures. Membro do conselho de inovação de diversas empresas e mentor e investidor em startups de IA. É autor de nove livros que abordam assuntos como Transformação Digital, Inovação, Big Data e Tecnologias Emergentes. Professor convidado da Fundação Dom Cabral, PUC-RJ e PUC-RS.