Confesso que sou um entusiasta da inteligência artificial (IA). E não é de agora. Lembro que na adolescência devorava livros de Isaac Asimov, como a famosa trilogia “Fundação” e, principalmente, “Eu, robô”, que foi uma série de contos que são um marco na história da ficção científica, pela introdução das célebres Leis da Robótica, e por um olhar completamente novo a respeito das máquinas.

Os robôs de Asimov conquistaram a cabeça e a alma de gerações de escritores, cineastas e cientistas, sendo até hoje fonte de inspiração de tudo o que lemos e assistimos sobre eles. Depois veio o inesquecível filme de Stanley Kubrick, “2001, uma odisseia no espaço” e com ele o HAL 9000 (Heuristically programmed ALgorithmic computer), que é um computador com avançada inteligência artificial, instalado a bordo da nave espacial Discovery e responsável por todo seu funcionamento.

Os diálogos dele com os atores me deixaram realmente impressionado com que o futuro poderia nos trazer. Quando li um paper sobre Eliza, software criado por pesquisadores do MIT, vi que a IA era possível sim, pois já nos anos 1960 um sistema conseguia interagir de forma razoável com humanos. Em meados dos anos 1980, consegui aprovação para colocar em prática uma experiência, dentro da empresa na qual trabalhava.

Na época o cenário da IA estava dividido em duas linhas de pensamento, um grupo que adotava o conceito de “rule-based”, também chamado de “expert systems” ou sistemas especialistas, e o grupo que se orientava pelo conceito de redes neurais (neural networks). As redes neurais pareciam muito promissoras, mas faltavam dados e a capacidade computacional disponível era imensamente inferior à que temos hoje.

Pragmaticamente optei pelos sistemas especialistas, pois a lógica de desenvolvimento me parecia mais factível: entrevistar profissionais especialistas em determinada área e codificar seus processos de decisão, em uma árvore de decisão, com If-Then-Else. Um sistema especialista tem dois componentes básicos: um motor de inferência e uma base de conhecimentos. A base de conhecimento tem os fatos e regras, e o motor de inferência aplica as regras aos fatos conhecidos e deduz novos fatos. Fui à luta. Entretanto, o sistema nunca funcionou adequadamente e foi descontinuado. Mas valeu a experiência.

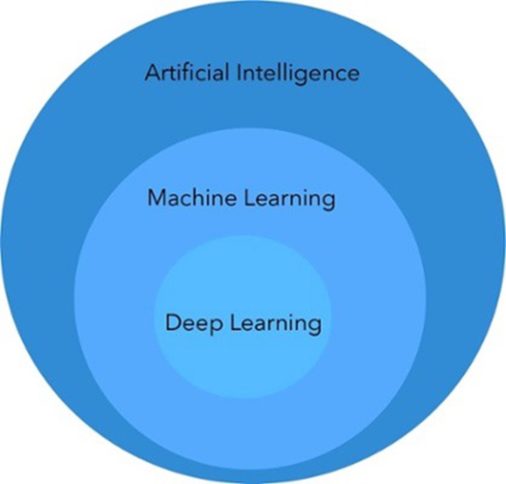

Portanto, não vem de hoje o interesse em IA. E, como vemos, a IA não é novidade. O termo foi cunhado na década de 1950, passou por altos e baixos e, agora, graças à capacidade computacional disponível e uma inundação de dados em formato digital, começa a tomar forma. Temos hoje condições de desenvolver algoritmos bastante sofisticados e uma forma específica de IA, deep learning, tem sido a grande aposta de sua evolução. Para muitos, deep learning é o atual estado da arte em IA.

É indiscutível que deep learning tem potencial de criar valor para muitas e muitas aplicações, permitindo a criação de soluções que não pensávamos ser possível alguns anos atrás. Por outro lado, apesar da potencialidade dos algoritmos de deep learning temos que entender suas limitações, para não imaginarmos que conseguiremos agora, resolver todos os problemas do mundo.

Mas o que é deep learning? É um subconjunto do aprendizado de máquina (machine learning) baseado em um modelo conceitual do cérebro humano chamado "redes neurais". É chamado de deep learning porque as redes neurais têm várias camadas que se interconectam: uma camada de entrada que recebe dados, camadas intermediárias que calculam os dados e uma camada de saída que fornece a análise.

Em síntese, deep significa profundidade dos níveis de redes neurais. As técnicas de deep learning são especialmente úteis para analisar dados complexos, ricos e multidimensionais, como voz, imagens e vídeo. Novas tecnologias e algoritmos estão facilitando o lançamento de projetos de deep learning pelas empresas e a sua adoção está aumentando. Em resumo, todo deep learning é machine learning, mas nem todo aprendizado de máquina é deep learning.

Para entendermos o que é IA e mais precisamente deep learning, precisamos primeiro desmitificar IA. As máquinas não são inteligentes e nem são mágicas. Na verdade, o termo Inteligência Artificial, criado por John McCarthy em 1956, talvez não seja o mais apropriado. Não sabemos bem como definir o conceito de inteligência e ainda por cima colocarmos o adjetivo artificial ao lado, torna as coisas confusas e gera um certo misticismo. Um quê de mágica.

Para entendermos o que é IA e mais precisamente deep learning, precisamos primeiro desmitificar IA. As máquinas não são inteligentes e nem são mágicas. Na verdade, o termo Inteligência Artificial, criado por John McCarthy em 1956, talvez não seja o mais apropriado. Não sabemos bem como definir o conceito de inteligência e ainda por cima colocarmos o adjetivo artificial ao lado, torna as coisas confusas e gera um certo misticismo. Um quê de mágica.

Mas IA é apenas um conjunto de técnicas e algoritmos, que, apenas exibem comportamento que nos parece ser inteligente. Por exemplo, na leitura de textos, nós, como humanos, analisamos a sentença, a descontruímos em substantivos, verbos e adjetivos, mas com a compreensão do todo. Conectamos a sentença com o que nós sabemos sobre o mundo à nossa volta, juntamos gírias e ironias com as ideias e intenções, até mesmo não explícitas, que entendemos fazer sentido.

As máquinas não entendem o significado das palavras. Elas conseguem interagir com as sentenças pois usam modelos matemáticos que definem estatisticamente que após cada palavra vem outra e escolhe por probabilidade qual será a escolhida. Para uma máquina, encontrar a palavra câncer em uma frase tem tanto significado quanto a palavra caneta. Não é afetada emocionalmente.

Claro, isso não a impede de simular inteligência e permitir que haja interação com uma pessoa através de um chatbot, parecendo mesmo que ela está entendendo o que a pessoa está dizendo. Mas, para isso, algoritmos de deep learning precisam ser treinados com um massivo e específico volume de dados.

Um chatbot que entenda uma pessoa em uma interação com um banco precisa ser treinado com milhões de interações de pessoas com os atendentes deste banco, para absorver a estrutura da interação. Mas, como deep learning é uma “narrow AI”, ou seja, precisa ser treinado para algo bem específico, não conseguimos pegar diretamente este chatbot de banco e colocá-lo para interagir com um usuário de um plano de saúde. Embora muitos diálogos sejam similares, aparecerão termos específicos do setor que o chatbot nunca viu e, portanto, não pôde ser treinado em como reagir adequadamente a eles.

A mesma coisa acontece se treinarmos algoritmos de tradução para traduzir documentos jurídicos. Eles não conseguirão traduzir documentos médicos, pois os termos serão completamente diferentes. Portanto, não temos como pegar um algoritmo treinado para fazer algo e pedir para ele fazer outra coisa. Mesmo um algoritmo treinado para interagir com um cliente de banco não conseguirá de imediato atender adequadamente um cliente de uma empresa aérea. Precisa ser retreinado com os dados das interações dos clientes com a empresa aérea. Deep learning não sabe reagir a situações insólitas.

As máquinas também não têm consciência. Quando o Watson venceu o “Jeopardy!” ele não saiu para comemorar com os amigos. Quando AlphaGo venceu Lee Sedol no Go, ele não teve a mínima ideia do que fez. Cumpriu o que seus algoritmos tinham que fazer e pronto. AlphaGo não sabe fazer outra coisa a não ser jogar Go. Não sabe jogar xadrez. Isso impede que usemos IA para atividades que demandam empatia. Por exemplo na saúde, a máquina pode fazer bem a análise de imagens, mas como na verdade não veem, mas simplesmente enxergam pixels, não podem substituir o médico nas interações onde os cuidados médicos demandam personalização e humanidade.

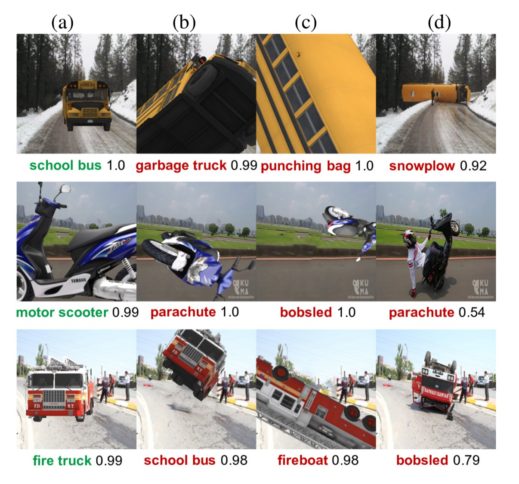

Uma outra limitação do deep learning é sua opacidade. Como não existem regras específicas e bem compreendidas, como em uma árvore de decisão, temos uma situação onde o mesmo algoritmo diante de dados diferentes toma atitudes diferentes. E não sabemos explicar o por quê! Em determinadas situações isso pode ser complicado. Imagine um algoritmo que acerta 95% das vezes e quando erra, em 5%, não sabemos o por quê errou.

Para determinadas aplicações precisamos ter total confiança na máquina. Como deep learning não consegue explicar o porquê de suas decisões e nem garantir resultados (lembrem-se que IA é probabilístico e não determinístico) não poderá ser aplicado a tudo. Você deixaria um robô cuidar de seu avô quando ele faria o atendimento correto 95% das vezes, mas o jogaria no chão ou pela janela nos outros 5%?

Além disso, como a máquina não tem senso comum, esses erros podem ser absurdos. A figura abaixo mostra que quando confrontado com o mesmo objeto, mas em posições diferentes das bases de dados onde foi treinado, o algoritmo pode produzir resultados estapafúrdios.

O que tudo isso significa? Vamos desistir de IA por que existem algumas limitações? Absolutamente não! Entender estas limitações nos ajudará a vencer os obstáculos e adotar IA de forma mais assertiva, sem criar falsas expectativas. Existe muita desinformação sobre IA e para que projetos adequados sejam desenvolvidos, não podemos superestimar suas funcionalidades.

O que tudo isso significa? Vamos desistir de IA por que existem algumas limitações? Absolutamente não! Entender estas limitações nos ajudará a vencer os obstáculos e adotar IA de forma mais assertiva, sem criar falsas expectativas. Existe muita desinformação sobre IA e para que projetos adequados sejam desenvolvidos, não podemos superestimar suas funcionalidades.

O realismo é essencial para que os projetos sejam desenhados como soluções reais para problemas de negócio. Por outro lado, não podemos subestimar seu potencial no longo prazo. Seu impacto nos próximos anos será equivalente a um tsunami chegando ao litoral. Basta ver que os smartphones surgiram em 2007 (anúncio do iPhone) e embora subestimados no início, mudou nossas vidas hoje.

IA e deep learning tem imenso potencial. A evolução acelerada da IA continua. Novos modelos de repensar os algoritmos de deep learning começam a aparecer, para resolver ou pelo menos minimizar as atuais limitações. O texto “Deep Learning Networks Can’t Generalize—But They’re Learning From the Brain” é um exemplo das pesquisas em andamento. Os processos de treinamento de algoritmos e sua evolução também tem sido alvo de muitas pesquisas. Olhem a compilação de artigos “Top AI Research Advances for Machine Learning Infrastructure” para termos uma visão melhor dos avanços na área.

Mas, precisamos ter plena consciência de quando e onde aplicar essas soluções. Existem muitas questões éticas e legais, existem desafios de criar soluções que sejam realmente adequadas e permitam que IA e humanos interajam de forma equilibrada e sinérgica. O artigo “Why We Should Be Careful When Developing AI” resume bem os desafios e cuidados que devemos ter com IA.

As máquinas não têm consciência. Quando o Watson venceu o “Jeopardy!” ele não saiu para comemorar com os amigos

Creio que esteja bem claro que IA é muito mais que uma simples tecnologia para ficar restrita a um setor específico dentro de uma empresa, como, por exemplo, o de TI. Como a eletricidade mudou e moldou nossa sociedade, a IA, mudará e moldará uma nova sociedade. Por isso países como a China criaram uma estratégia de Estado para IA. O estudo “Future in the balance? How countries are pursuing an AI advantage” mostra alguns exemplos de países que estão bem avançados nas suas estratégias de IA.

IA não é algo para ficar a cargo de gestores de nível médio nas empresas. Os países e as empresas (e nós como pessoas) devemos ter uma estratégia de IA. Nossas carreiras e profissões serão redesenhadas. Empresas serão criadas e outras extintas. Poder geopolítico e econômico será modificado substancialmente. Hoje temos um risco: a maior parte do conhecimento de IA está nas mãos de nove empresas, seis americanas e três chinesas.

Ainda não temos máquinas que pensam. Mas somos capazes de um dia fabricarmos estas máquinas. Evoluiremos do deep learning para o deep understanding. Neste processo, precisamos fazer com que estas máquinas saibam distinguir o bem do mal. Por isso, é que a IA é importante demais para ser deixada apenas nas mãos dos engenheiros de ML. Precisamos de diversidade de ideias e percepções para que realmente venhamos a ter uma verdadeira IA. Quando isso acontecer, não usaremos mais o termo IA. Já estará tão entranhada e invisível nas nossas vidas que não precisaremos mais chamá-la de nada. Ela já estará lá.

*Cezar Taurion é Partner e Head of Digital Transformation da Kick Corporate Ventures e presidente do i2a2 (Instituto de Inteligência Artificial Aplicada). É autor de nove livros que abordam assuntos como Transformação Digital, Inovação, Big Data e Tecnologias Emergentes. Professor convidado da Fundação Dom Cabral. Antes, foi professor do MBA em Gestão Estratégica da TI pela FGV-RJ e da cadeira de Empreendedorismo na Internet pelo MBI da NCE/UFRJ.